[ep11] Le Magic words de Disney : l'armée invisible des métadonnées IA

Dans l'univers foisonnant de la production audiovisuelle contemporaine, où Netflix produit plus de 15 000 heures de contenu original par an et où YouTube voit 500 heures de vidéo téléchargées chaque minute, la gestion des métadonnées représente un défi colossal. Ces "données sur les données" constituent l'épine dorsale invisible de l'industrie du divertissement, permettant la recherche, la recommandation, la monétisation et la distribution des contenus à l'échelle planétaire.

L'émergence de l'intelligence artificielle dans ce domaine promet de transformer radicalement les processus traditionnels d'indexation et de catalogage. Là où des équipes entières passaient des semaines à analyser et taguer manuellement les contenus, les algorithmes de computer vision et de traitement du langage naturel peuvent désormais extraire automatiquement une richesse d'informations en quelques heures. Cette révolution technologique soulève des questions fondamentales : l'IA peut-elle vraiment remplacer l'expertise humaine dans la compréhension des nuances créatives et culturelles ? Quels sont les enjeux économiques et éthiques de cette automatisation massive ?

L'héritage artisanal de la création de métadonnées

Traditionnellement, la création de métadonnées audiovisuelles relève d'un processus minutieux et largement manuel. Les documentalistes et archivistes visionnent intégralement les œuvres pour en extraire les informations essentielles : générique complet, synopsis détaillé, mots-clés thématiques, codes temporels des séquences importantes, identification des personnages principaux, analyse des émotions véhiculées, classification par genre et sous-genre.

Cette approche artisanale présente des avantages indéniables en termes de précision et de compréhension contextuelle. Un documentaliste expérimenté peut saisir les subtilités narratives, identifier les références culturelles implicites, détecter les enjeux sociétaux abordés et anticiper les réactions du public. Cette expertise humaine s'avère particulièrement précieuse pour les contenus complexes, les œuvres d'auteur ou les productions culturellement spécifiques.

Cependant, cette méthode traditionnelle se heurte à des limites structurelles face à l'explosion des volumes de production. Le coût humain de l'indexation manuelle peut représenter jusqu'à 15% du budget de post-production d'une série télévisée. Les délais de traitement, souvent incompatibles avec les exigences de diffusion en temps réel, constituent un autre obstacle majeur. Enfin, la subjectivité inhérente à l'analyse humaine peut générer des incohérences dans le catalogage, compliquant les recherches automatisées et la personnalisation des recommandations.

L'irruption de l'IA dans l'univers des métadonnées

C'est dans ce contexte de tension entre qualité artisanale et efficacité industrielle que l'intelligence artificielle fait son entrée fracassante. Les technologies de computer vision permettent désormais d'analyser automatiquement le contenu visuel des vidéos, identifiant objets, personnages, lieux, actions et émotions avec une précision croissante 1. Les algorithmes de traitement du langage naturel peuvent extraire des informations sémantiques à partir des dialogues, sous-titres et scripts, générant automatiquement des résumés, des mots-clés et des classifications thématiques.

L'Union européenne de radiodiffusion (EBU) a été pionnière dans ce domaine avec son projet d'extraction automatique de métadonnées (AME), développé entre 2020 et 2022. Cette initiative visait à créer des outils d'IA capables de générer des tags de haut niveau à partir de contenus écrits, utilisant des techniques avancées de traitement du langage naturel et d'apprentissage automatique 1. Le projet EBU LynX, en particulier, a démontré la capacité de l'IA à analyser les propriétés linguistiques des contenus pour la détection de fausses nouvelles, l'identification d'auteurs et l'analyse d'audience ciblée.

Cette approche automatisée présente des avantages considérables en termes de rapidité et de cohérence. Les algorithmes peuvent traiter des heures de contenu en quelques minutes, appliquant des critères d'analyse uniformes et reproductibles. La scalabilité de ces solutions permet de gérer des volumes de données impossibles à traiter manuellement, ouvrant la voie à des analyses exhaustives de catalogues entiers.

Netflix : pionnier de l'extraction automatique à grande échelle

Netflix s'est imposé comme le leader incontesté de l'automatisation des métadonnées, développant des technologies propriétaires pour analyser sa bibliothèque de contenus de près de deux millions d'images et des milliers d'heures de vidéo 2. La plateforme utilise des algorithmes de computer vision sophistiqués pour résoudre trois défis majeurs : la détermination du point focal des images, le placement optimal de texte et le clustering d'images similaires.

Le système de détection de point focal de Netflix utilise des caractéristiques de type Haar-cascade pour identifier automatiquement les personnes et leur positionnement corporel, déterminant s'il s'agit d'un plan rapproché, d'un plan américain ou d'un plan d'ensemble. Pour les images sans présence humaine, l'algorithme applique un flou gaussien suivi d'une détection de contours pour identifier les régions les plus intéressantes visuellement 2.

La technologie de placement de texte développée par Netflix résout un problème crucial : éviter de superposer des badges ou sous-titres sur du texte existant dans l'image. L'algorithme de détection de texte applique plusieurs transformations (watershed, seuillage) avant l'analyse, permettant d'obtenir une probabilité précise de présence de texte dans une région d'intérêt 2.

Résultat final avec valeurs d'indice de similarité - source Netflix

Le système de clustering d'images de Netflix utilise une combinaison de quatre paramètres pour déterminer un indice de similarité : distance basée sur l'histogramme, similarité structurelle, correspondance de caractéristiques et algorithme Earth Mover's Distance pour mesurer la similarité colorimétrique globale. Cette approche permet de regrouper automatiquement des images visuellement similaires malgré des variations de recadrage, de correction colorimétrique et de traitement de titre 2.

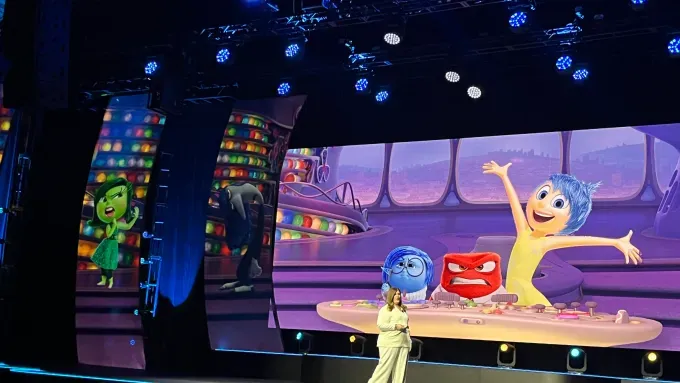

Disney et la révolution des "Magic Words"

Disney a franchi une étape supplémentaire avec le développement de son système "Magic Words", un outil d'IA qui analyse et tague automatiquement les scènes de sa bibliothèque pour identifier le contenu, les marques, les images et l'ambiance 3. Cette technologie utilise une combinaison d'intelligence artificielle et d'apprentissage automatique pour créer des métadonnées descriptives permettant aux annonceurs d'identifier des scènes ou ambiances spécifiques et de personnaliser leurs messages en conséquence.

Magic Words de Disney, un concept très pragmatique - source disneyadvertising

Le système "Magic Words" représente une nouvelle forme de publicité contextuelle pour les services de streaming Disney+ et Hulu. Selon Rita Ferro, responsable mondiale des ventes publicitaires de Disney, cette fonctionnalité permet aux annonceurs de maximiser l'impact de leurs messages "parce qu'elle résonne avec les concepts que vivent les spectateurs" 3.

Cette innovation s'inscrit dans la stratégie plus large de Disney d'investissement dans la technologie publicitaire de streaming, alors que les annonceurs se détournent de la télévision traditionnelle. La version avec publicité de Disney+ a attiré plus de 1 000 annonceurs au premier trimestre, soit une multiplication par dix depuis le lancement 3.

France Télévisions et l'IA cognitive pour journalistes

Chez nous, France Télévisions a développé une approche innovante de l'extraction de métadonnées en partenariat avec Moments Lab, créant une plateforme d'IA cognitive spécifiquement conçue pour les journalistes 4. Cette solution centralise et analyse tous les contenus dans le cloud en temps réel, permettant aux journalistes d'extraire des séquences pertinentes parmi des milliers d'heures d'archives.

Analyse du Cloud en temps réel pour les journalistes de

La plateforme développée pour France Télévisions illustre l'adaptation de l'IA aux besoins spécifiques du journalisme audiovisuel. L'outil peut identifier automatiquement les personnalités politiques, analyser les discours, détecter les événements significatifs et proposer des extraits contextualisés pour l'actualité. Cette approche cognitive de l'IA va au-delà de la simple reconnaissance d'objets pour intégrer une compréhension sémantique du contenu journalistique.

L'initiative de France Télévisions s'inscrit dans une démarche plus large d'adoption de l'IA par le groupe public français. En avril 2025, France Télévisions a organisé une journée entière consacrée à l'IA, proposant à tous ses employés l'accès à medIAGen, une plateforme sécurisée centralisant différents modèles d'IA comme ChatGPT, Gemini, Mistral et Claude 5.

Les défis techniques de l'automatisation

Malgré les progrès spectaculaires de l'IA, l'extraction automatique de métadonnées se heurte encore à des défis techniques considérables. Le premier concerne la compréhension contextuelle : si les algorithmes excellent dans l'identification d'objets et d'actions, ils peinent encore à saisir les nuances narratives, les références culturelles implicites et les enjeux émotionnels complexes.

La gestion de la polysémie constitue un autre obstacle majeur. Un même objet ou une même action peut revêtir des significations différentes selon le contexte narratif, le genre cinématographique ou la culture de production. Les algorithmes actuels ont tendance à privilégier les interprétations les plus fréquentes, manquant parfois les subtilités créatives qui font la richesse des œuvres audiovisuelles.

La qualité variable des contenus sources pose également des défis techniques. Les algorithmes de computer vision peuvent être perturbés par des conditions d'éclairage difficiles, des mouvements de caméra complexes ou des effets visuels sophistiqués. De même, les systèmes de traitement du langage naturel peuvent être mis en difficulté par des dialogues avec accents marqués, des langues régionales ou des créations linguistiques propres à certaines œuvres de fiction.

Enfin, la question de la mise à jour et de l'évolution des modèles reste problématique. Les références culturelles, les tendances esthétiques et les codes narratifs évoluent constamment, nécessitant une adaptation permanente des algorithmes. Cette maintenance continue représente un coût et une complexité technique non négligeables pour les organisations qui déploient ces solutions.

L'impact économique sur l'industrie audiovisuelle

L'automatisation de la création de métadonnées bouleverse l'économie traditionnelle de l'industrie audiovisuelle. Les entreprises spécialisées dans l'indexation manuelle, qui emploient des milliers de documentalistes et d'archivistes dans le monde, s'interrogent sur leur modèle économique futur. Certaines anticipent une réduction drastique des coûts de traitement, d'autres craignent une dévalorisation de l'expertise humaine.

Les plateformes de streaming, principales bénéficiaires de cette automatisation, investissent massivement dans ces technologies. Netflix consacre une part significative de son budget R&D au développement d'outils d'analyse automatique de contenu 6. L'objectif : personnaliser à l'extrême l'expérience utilisateur et maximiser l'engagement sur leurs plateformes.

Cette transformation s'accompagne d'une redéfinition des compétences professionnelles. Les documentalistes traditionnels évoluent vers des rôles de superviseurs d'IA, de formateurs d'algorithmes ou de spécialistes de l'optimisation des systèmes automatisés. Certains développent une expertise dans le "prompt engineering" pour les modèles de langage, d'autres se spécialisent dans la validation et la correction des métadonnées générées automatiquement.

auto-tagging - source ikonic

L'émergence de nouveaux acteurs technologiques spécialisés dans l'IA de métadonnées crée également de nouvelles opportunités économiques. Des entreprises comme Iconik proposent des solutions d'auto-tagging basées sur l'IA 7, tandis que des startups comme TagifyAI développent des outils spécialisés dans le tagging vidéo automatique 8.

Les enjeux éthiques et de qualité

L'automatisation de la création de métadonnées soulève des questions éthiques complexes qui dépassent les seuls enjeux techniques. La première concerne la représentation et les biais algorithmiques : les systèmes d'IA peuvent reproduire et amplifier les préjugés présents dans leurs données d'entraînement, conduisant à des classifications biaisées ou discriminatoires.

La question de la transparence algorithmique constitue un autre enjeu majeur. Les utilisateurs finaux - spectateurs, créateurs, distributeurs - ont-ils le droit de comprendre comment leurs contenus sont analysés et catégorisés ? Cette opacité peut avoir des conséquences importantes sur la visibilité et la monétisation des œuvres.

La propriété intellectuelle des métadonnées générées automatiquement pose également des questions juridiques inédites. Qui détient les droits sur les analyses et classifications produites par l'IA ? Cette interrogation devient cruciale quand ces métadonnées constituent un avantage concurrentiel pour les plateformes de streaming.

Enfin, la dépendance croissante aux systèmes automatisés suscite des inquiétudes sur la perte de diversité culturelle. Les algorithmes ont tendance à privilégier les patterns majoritaires, risquant de marginaliser les œuvres atypiques ou culturellement spécifiques qui enrichissent pourtant l'écosystème audiovisuel.

Vers des modèles hybrides humain-IA

Face à ces défis, l'industrie audiovisuelle s'oriente progressivement vers des modèles hybrides combinant l'efficacité de l'IA et l'expertise humaine. Ces approches collaboratives visent à tirer parti des forces respectives de chaque approche : rapidité et cohérence pour l'IA, compréhension contextuelle et créativité pour l'humain.

Google Cloud Video Intelligence illustre cette tendance avec sa plateforme qui permet d'extraire des métadonnées riches au niveau vidéo, plan ou image, tout en offrant des possibilités de supervision et de correction humaine 9. Cette approche permet de traiter automatiquement les tâches répétitives tout en préservant un contrôle qualité humain sur les aspects les plus complexes.

Google Cloud Video Intelligence - source Medium

Les workflows hybrides émergents intègrent généralement plusieurs étapes : pré-traitement automatique par l'IA, validation sélective par des experts humains, correction et enrichissement manuel des métadonnées critiques, et apprentissage continu des algorithmes à partir des corrections apportées. Cette boucle de rétroaction permet d'améliorer progressivement la performance des systèmes automatisés.

L'avenir de la création de métadonnées semble ainsi s'orienter vers une collaboration étroite entre intelligence artificielle et expertise humaine, chacune apportant ses forces spécifiques pour relever les défis de l'industrie audiovisuelle contemporaine. Cette évolution nécessitera des investissements importants en formation et en adaptation des compétences, mais promet d'ouvrir de nouvelles perspectives créatives et économiques pour l'ensemble de l'écosystème.

© Une série produite par KILL THE TAPE, plateforme de Gestion, Conservation et labo en ligne

Références

[1] EBU Technology & Innovation - AI and Automatic Metadata Extraction : https://tech.ebu.ch/groups/ame

[2] Netflix Tech Blog - Extracting image metadata at scale : https://netflixtechblog.com/extracting-image-metadata-at-scale-c89c60a2b9d2

[3] Economic Times - Disney harnesses AI to drive streaming ad-technology : https://m.economictimes.com/tech/technology/disney-harnesses-ai-to-drive-streaming-ad-technology/articleshow/107558722.cms

[4] Moments Lab - France Televisions x Moments Lab: Bringing Cognitive AI to journalists : https://www.momentslab.com/customer-stories/france-televisions-newsbridge-bringing-cognitive-ai-to-journalists

[5] France Télévisions - A day devoted to AI at France Télévisions : https://www.francetelevisions.fr/et-vous/le-lab/en/tech/a-day-devoted-to-ai-at-france-t-l-visions-42191

[6] Wasabi - Understand AI Tagging: What is it and how does it work? : https://wasabi.com/blog/technology/what-is-ai-tagging

[7] Iconik - AI Video Tagging Software : https://www.iconik.io/artificial-intelligence

[8] TagifyAI - AI-Powered Video Tagging for Every Need : https://www.tagifyai.com/

[9] Google Cloud - Video AI and intelligence : https://cloud.google.com/video-intelligence

LABO KILL THE TAPE : 16, rue de Charonne - 75011 Paris.

Ouverture du lundi au vendredi de 10h à 13h et de 14h à 19h.

Tél : 01 86 95 24 25

Nous suivre :

KILLTHETAPE - Copyright © 2025 - Mentions légales

![[ep10] Bandes-annonces automatisées : Quand l'IA réinvente l'art du teasing](/uploads/images/1752233626300-68933ec6424e6.png)